Depuis l’avènement de ChatGPT, l’industrie de l’IA s’est focalisée sur les grands modèles de langage (LLM – Large Language Models). Des géants comme Google, Meta ou Microsoft, mais aussi des startups prometteuses comme Anthropic, ont tous misé sur ces mastodontes de l’IA. Cependant, l’entraînement et l’utilisation de ces modèles géants nécessitent d’importantes ressources de calcul, ce qui les rend coûteux et énergivores.

Face à ce constat, de plus en plus d’acteurs se tournent vers les petits modèles de langage (SLM – Small Language Models). Bien que moins performants que les meilleurs LLM, ils offrent un excellent rapport qualité-prix. Pour cette raison, ils ouvrent la voie à une démocratisation de l’IA. Google avec Gemma, Anthropic avec Claude Haiku, Meta avec Llama et maintenant Microsoft avec son modèle Phi-3 Mini, ont tous investi dans cette voie prometteuse.

Phi-3 Mini : un poids plume qui fait le poids

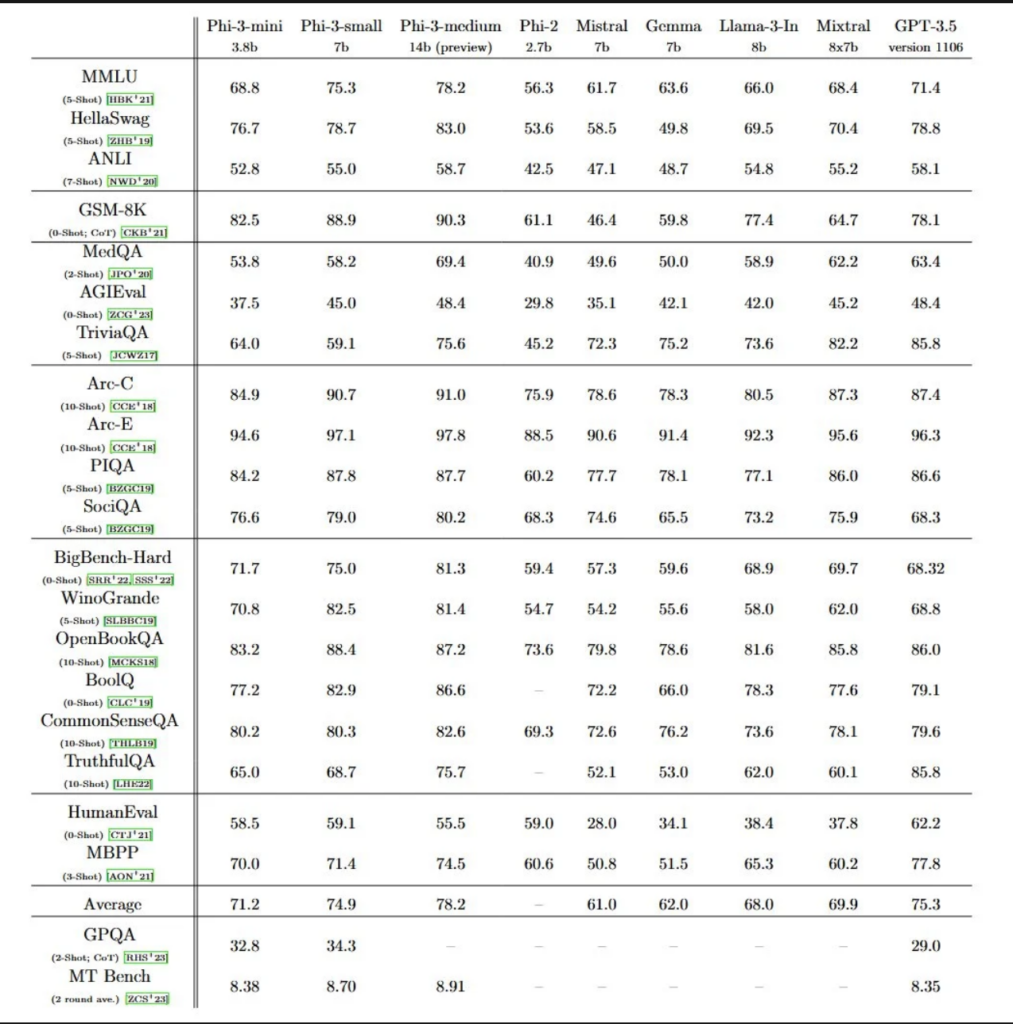

Phi-3 Mini ne compte que 7 milliards de paramètres, ce qui est minuscule comparé aux 1760 milliards de GPT-4. En IA, les paramètres sont les poids et les biais qui définissent l’importance des liens entre les neurones virtuels du réseau. Plus il y en a, plus le modèle est théoriquement capable d’apprendre et de réaliser des tâches complexes. Pourtant, selon Microsoft, les performances de ce petit modèle rivaliseraient avec celles de modèles 10 fois plus lourds. Ainsi, il soutient la comparaison avec GPT-3.5, l’ancien leader du marché.

Note : Les modèles Phi-3 n’atteignent pas de performances aussi élevées sur les benchmarks de connaissances factuelles (comme TriviaQA). En effet, leur plus petite taille réduit leur capacité à retenir les faits.

Les premiers benchmarks semblent confirmer ces affirmations audacieuses. Sur une série de tests évaluant les capacités linguistiques, de raisonnement, de codage et de mathématiques, Phi-3 Mini surpasse les modèles de même taille et même ceux de la catégorie supérieure. Mais comment Microsoft a-t-il réussi ce tour de force ?

Le secret de Phi-3 : miser sur la qualité des données

Pour obtenir de telles performances, les ingénieurs de Microsoft ont mis au point une méthode d’entraînement originale inspirée de l’apprentissage des enfants. Au lieu de nourrir le modèle avec une quantité astronomique de données glanées sur le web, ils ont misé sur un corpus restreint mais de haute qualité.

Tout a commencé avec un ensemble de 3000 mots simples, compréhensibles par un enfant de 4 ans. Un LLM a ensuite généré des millions de petites histoires à partir de ce vocabulaire. Ce corpus baptisé “TinyStories” a servi de base pour entraîner Phi-3.

Les chercheurs ont ensuite sélectionné méticuleusement des données publiques triées sur leur valeur pédagogique et leur clarté. L’objectif : fournir au modèle un contenu limpide et explicite pour faciliter son apprentissage. Cette méthode reproduit la manière d’un professeur qui décortique un concept complexe.

Cette approche a permis d’obtenir des résultats étonnants malgré la petite taille du modèle. Lorsqu’on lui a demandé de créer ses propres histoires, Phi-3 a généré des récits fluides et cohérents, avec une grammaire parfaite. Preuve que la qualité prime sur la quantité.

Des petits modèles taillés pour des usages spécifiques

les LLM restent indispensables pour les tâches complexes nécessitant une analyse poussée de grandes quantités d’informations, comme la découverte de médicaments. Cependant, les SLM ont un rôle clé à jouer dans de nombreux scénarios.

Leur petite taille les rend particulièrement adaptés aux environnements contraints en ressources, comme les appareils mobiles ou les systèmes embarqués. Ils peuvent fonctionner localement, sans connexion au cloud, ce qui réduit la latence et renforce la confidentialité des données.

Les SLM sont aussi plus abordables et plus faciles à personnaliser pour des besoins spécifiques. Leur faible coût de fonctionnement en fait une option intéressante pour les cas d’usage simples où la rapidité de réponse est cruciale.

Phi-3 Mini, par exemple, pourrait être utilisé pour :

- résumer les points clés d’un long document

- extraire des informations pertinentes de rapports d’étude de marché

- générer du contenu marketing comme des descriptions de produits ou des posts sur les réseaux sociaux

- alimenter un chatbot de support client pour répondre aux questions basiques.

Vers un nouveau paradigme pour l’IA grand public ?

Cette approche privilégiant la qualité à la quantité ouvre des perspectives intéressantes. Appliquée à des modèles plus conséquents, elle pourrait donner naissance à une nouvelle génération d’IA. Celles-ci serait performantes tout en étant bien moins gourmandes en ressources.

Car actuellement, la course à l’armement des LLM se heurte à des limites physiques et logistiques. La puissance de calcul nécessaire explose à chaque génération, avec un impact sur les coûts et l’environnement. Les géants de la tech se livrent une guerre sans merci pour acheter un maximum de GPU. Cela aboutit à mettre sous pression des chaînes d’approvisionnement déjà tendues.

Dans ce contexte, les petits modèles comme Phi-3 pourraient devenir le nouveau standard pour démocratiser l’IA auprès du grand public. Moins chers, plus accessibles, ils permettraient de proposer des agents conversationnels de qualité sans dépendre d’une infrastructure de supercalculateurs.

On peut imaginer des modèles IA spécialisés dans le filtrage et la synthèse des données d’entraînement. Ainsi, les performances seraient améliorées sans faire exploser la taille des modèles. À terme, cela pourrait déboucher sur une nouvelle génération d’IA compactes mais étonnamment capables, adaptées à une multitude d’usages du quotidien.

Des cas d’usage prometteurs dans de nombreux secteurs

Les petits modèles comme Phi-3 ont un potentiel immense dans de nombreux domaines. Ils pourraient par exemple révolutionner l’agriculture en permettant aux fermiers d’obtenir des conseils personnalisés directement sur le terrain, sans dépendre d’une connexion internet.

Équipé d’un smartphone doté d’un SLM, un agriculteur pourrait prendre en photo une feuille malade et recevoir immédiatement des recommandations sur le traitement à appliquer. Une perspective particulièrement intéressante pour les zones rurales mal desservies par les réseaux mobiles.

Dans l’industrie, les SLM pourraient être déployés sur des capteurs et des machines. Ils permettraient ainsi d’analyser les données en temps réel et détecter d’éventuels problèmes avant qu’ils ne dégénèrent. Ils ouvriraient la voie à une maintenance prédictive plus efficace et moins coûteuse.

Les petits modèles pourraient aussi jouer un rôle clé dans les secteurs régulés. Ainsi, ils pourraient être utilisés dans la santé ou la finance, où la confidentialité des données est cruciale. En permettant de traiter les informations sensibles localement, sans les exposer sur le cloud, ils offriraient un haut niveau de sécurité tout en apportant les bénéfices de l’IA.

Conclusion : un avenir prometteur pour les petits modèles

S’il est encore trop tôt pour enterrer les LLM, l’approche de Microsoft avec Phi-3 Mini ouvre des perspectives passionnantes. En misant sur la qualité des données plutôt que sur la quantité, il devient possible de créer des modèles compacts mais étonnamment capables.

Cette tendance pourrait bien se transformer en nouveau paradigme dans un futur proche. Des modèles IA spécialisés dans le filtrage et la synthèse des données d’entraînement pourraient voir le jour, permettant d’améliorer les performances sans faire exploser la taille des modèles.

L’avenir nous dira si les petits modèles comme Phi-3 s’imposeront face aux mastodontes actuels. Mais une chose est sûre : ils ont un rôle clé à jouer pour rendre l’IA plus accessible, abordable et omniprésente dans notre quotidien.

De l’agriculture à l’industrie en passant par la santé et la finance, les SLM ont le potentiel de révolutionner de nombreux secteurs. En apportant l’intelligence artificielle au plus près des utilisateurs, ils ouvrent la voie à une nouvelle ère. Une ère dans laquelle l’IA ne sera plus l’apanage des géants de la tech mais un outil à la portée de tous.

Reste à voir comment cette technologie prometteuse évoluera dans les années à venir. Une chose est sûre : Microsoft, avec Phi-3, a posé une première pierre dans l’édifice des petits modèles. Et nul doute que d’autres acteurs lui emboîteront le pas pour explorer cette voie pleine de promesses.

Source : Microsoft